Cơ quan chức năng cảnh báo người dân cẩn thận trước những cuộc gọi video có tín hiệu chập chờn, mạo danh người thân đang cần dùng tiền gấp để yêu cầu chuyển tiền của đối tượng lừa đảo.

Theo thông tin ghi nhận, mới đây, một người phụ nữ tên N.T.T. (trú phường Linh Tây, TP. Thủ Đức, TP.HCM) đã trở thành nạn nhân của chiêu trò lừa đảo tinh vi. Chị T. kể lại, trong lúc đang ngồi làm việc thì nhận được tin nhắn của bạn thân qua Facebook hỏi mượn số tiền 20 triệu đồng để đáo hạn ngân hàng.

Chị T. ngay lập tức cảnh giác, nghi ngờ người bạn này đã bị đối tượng xấu chiếm đoạt tài khoản Facebook nhằm đánh lừa những người trong danh sách bạn bè. Chính vì vậy, chị T. đã gọi điện thoại bằng video cho người bạn ấy để kiểm tra.

Phía bên kia cũng không do dự bắt máy lập tức. Sau khi mở video, chị T. thấy hình ảnh khá mờ, không rõ ràng, tín hiệu chập chờn. Chị T. có hỏi vì sao không nhìn rõ video thì đối phương dùng giọng giống hệt người bạn thân của chị T. trả lời "đang ở vùng sóng yếu".

Sau khi đã kiểm tra, chị T. tin tưởng chuyển 20 triệu đồng vào số tài khoản mà đối phương cung cấp. Khoảng 30 phút sau, chị T. càng nghĩ càng thấy bất an. Vì thế chị T. dùng số điện thoại gọi cho bạn thân hỏi thăm tình hình thì mới biết mình đã bị lừa.

Đây không phải lần đầu tiên có trường hợp bị lừa đảo tiền thông qua cách thức ghép mặt, giả giọng nói qua những cuộc gọi video. Trước đó, một trường hợp của chị V.T.M. (trú tại Long Biên, TP. Hà Nội) cũng bị lừa mất 75 triệu đồng. Mặc dù cảnh giác nhưng người thân này của chị M. đã sang nước ngoài sinh sống, chỉ có thể kiểm tra thông tin bằng cách gọi video.

Tuy tín hiệu rất kém, hình ảnh mờ nét nhưng chị M. cũng đã xác nhận được là "người thân" của mình và chuyển số tiền 75 triệu đồng cho đối phương. Đến tối, chị M nhìn thấy bài đăng của người thân mình thông báo về việc bị "hack" tài khoản thì chị M. mới vỡ lẽ là bản thân bị lừa.

Chiều ngày 25/3, Công an tỉnh Tuyên Quang cho biết, hiện nay, rất nhiều đối tượng xấu lợi dụng sự kết nối trên không gian mạng đã thực hiện nhiều phương thức chiếm đoạt tài sản vô cùng tinh vi, một trong số đó là sử dụng công nghệ ghép mặt - giả giọng nói bằng trí tuệ nhân tạo (AI).

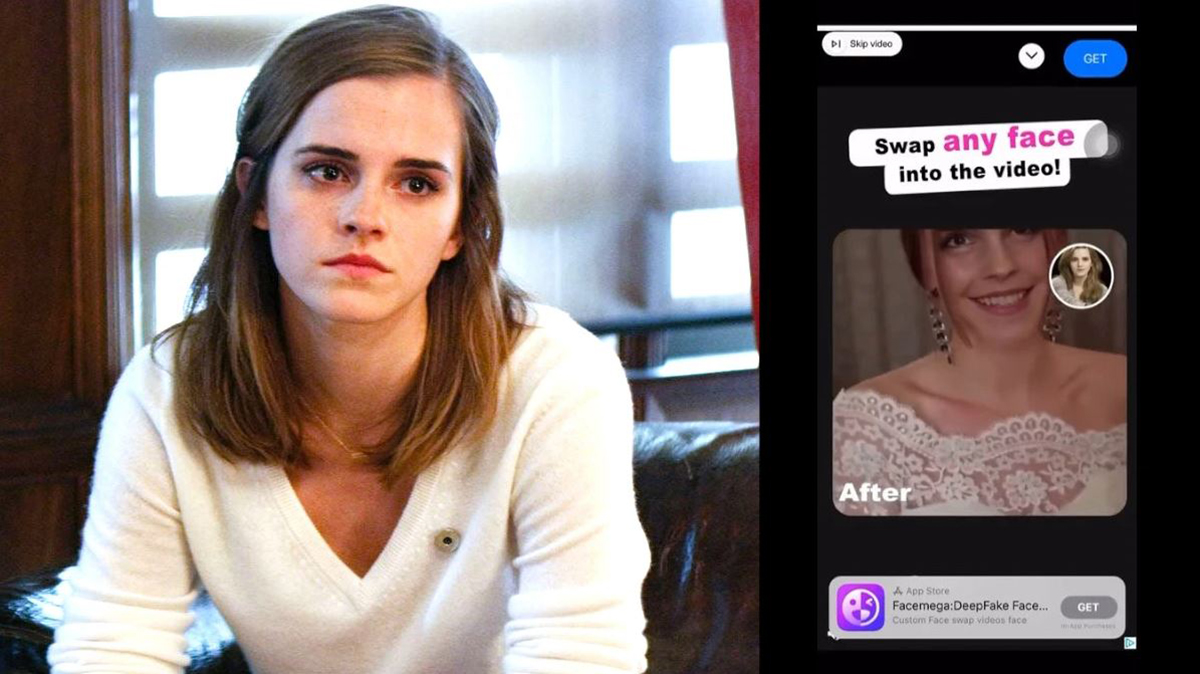

Một số công cụ như Deepfake AI đã tạo ra sản phẩm công nghệ có cả âm thanh, hình ảnh và video không khác gì người thật với mức độ chính xác rất cao. Năm 2019, một công ty năng lượng đã bị lừa 243.000 USD (hơn 5,7 tỷ đồng) chỉ bằng một đoạn giọng nói mô phỏng của ông chủ để ra lệnh cho nhân viên chuyển tiền. Năm 2022, ước tính số tiền bị lừa bằng công cụ này đã lên đến 11 triệu USD (gần 259 tỷ đồng).

Các đối tượng cho biết hiện đang cần số tiền để dùng cho việc rất gấp ví như chuyển tiền học phí cho con du học nước ngoài, đóng tiền hư hại phương tiện, cấp cứu tai nạn... để buộc "con mồi" rơi vào trạng thái lúng túng, cấp bách và thực hiện theo yêu cầu lừa đảo của chúng.

Để thực hiện được phương thức này, nhóm đối tượng lừa đảo đã tìm kiếm, thu thập thông tin cá nhân, hình ảnh, video có giọng nói được đăng tải khắp các mạng xã hội. Sau đó, chúng dùng công nghệ Deepfake AI để tạo sẵn những video khó phân biệt thật - giả (thường lấy lý do là vùng sóng yếu, kém kết nối - PV) để lừa đảo.

Từ những điều trên, Công an tỉnh Tuyên Quang khuyến cáo và đề nghị mọi người nâng cao cảnh giác khi nhận được bất kỳ tin nhắn, cuộc gọi video với nội dung vay tiền, chuyển tiền thông qua các ứng dụng mạng xã hội.

Người dân nên hết sức bình tĩnh, kiểm tra bằng mọi cách như dễ dàng nhất là liên lạc bằng số điện thoại với người thân hoặc hỏi han thông tin thật kỹ trước khi quyết định chuyển tiền. Trường hợp xuất hiện nghi vấn, người dân cần báo cáo ngay cho cơ quan chức năng gần nhất để được hỗ trợ và xử lý kịp thời.

Ảnh: Tổng hợp